- Что такое WordPress Robots.txt?

- Почему вы должны заботиться о своем файле Robots.txt?

- Robots.txt не касается конкретно того, какие страницы индексируются в поисковых системах

- Как создать и отредактировать файл WordPress Robots.txt

- Как создать и отредактировать файл Robots.txt с помощью Yoast SEO

- Как создать и отредактировать файл Robots.txt со всеми в одном SEO

- Как создать и редактировать файл Robots.txt через FTP

- Что положить в ваш файл Robots.txt

- Как использовать Robots.txt, чтобы заблокировать доступ ко всему сайту

- Как использовать Robots.txt, чтобы заблокировать доступ одного сайта к вашему сайту

- Как использовать Robots.txt, чтобы заблокировать доступ к определенной папке или файлу

- Как использовать Robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

- Как использовать Robots.txt, чтобы остановить роботов от сканирования результатов поиска WordPress

- Как создать разные правила для разных ботов в Robots.txt

- Тестирование вашего файла Robots.txt

- Остерегайтесь спецификации UTF-8

- Googlebot в основном в США

- Какие популярные сайты WordPress помещают в свои файлы Robots.txt

- TechCrunch

- Фонд Обамы

- Angry Birds

- дрейф

- Используйте Robots.txt правильный путь

Когда-нибудь слышали термин robots.txt и задавались вопросом, как он применяется к вашему сайту? Большинство веб-сайтов имеют файл robots.txt, но это не означает, что большинство веб-мастеров понимают его. В этом посте мы надеемся изменить это, предложив глубокое погружение в файл WordPress robots.txt, а также узнав, как он может контролировать и ограничивать доступ к вашему сайту. К концу вы сможете ответить на такие вопросы, как:

Есть много чего, так что давайте начнем!

Что такое WordPress Robots.txt?

Прежде чем мы сможем поговорить о WordPress robots.txt, важно определить, что такое «робот» в этом случае. Роботы - это любой тип «бота», который посещает веб-сайты в Интернете. Наиболее распространенный пример - поисковые роботы. Эти боты «ползают» по сети, чтобы помочь таким поисковым системам, как индекс Google, и ранжировать миллиарды страниц в Интернете.

Итак, боты, в общем , полезны для Интернета ... или, по крайней мере, необходимы. Но это не обязательно означает, что вы или другие веб-мастера хотите, чтобы боты бегали без ограничений. Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию стандарта исключения роботов в середине 1990-х годов. Robots.txt является практической реализацией этого стандарта - он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом . Вы можете полностью блокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Эта «участвующая» часть важна. Robots.txt не может заставить бота следовать его директивам. А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют некоторые команды, которые вы можете поместить в Robots.txt. Например, Google будет игнорировать любые правила что вы добавляете в свой robots.txt информацию о том, как часто посещают его сканеры. Если у вас много проблем с ботами, решение для безопасности, такое как Cloudflare или же Sucuri может пригодиться.

Почему вы должны заботиться о своем файле Robots.txt?

Для большинства веб-мастеров преимущества хорошо структурированного файла robots.txt сводятся к двум категориям:

- Оптимизация ресурсов сканирования поисковых систем, сказав им не тратить время на страницы, которые вы не хотите индексировать. Это помогает поисковым системам сосредоточиться на сканировании страниц, которые вас интересуют больше всего.

- Оптимизация использования ваших исследований путем блокировки ботов, которые тратят ресурсы вашего сервера.

Robots.txt не касается конкретно того, какие страницы индексируются в поисковых системах

Robots.txt не является надежным способом контроля того, какие страницы индексируют поисковые системы. Если ваша основная цель состоит в том, чтобы запретить включение определенных страниц в результаты поиска, правильный подход заключается в используйте мета-тэг noindex или другой аналогичный прямой метод.

Это потому, что ваш Robots.txt прямо не говорит поисковым системам не индексировать контент - он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, Сам гугл заявляет что если внешний сайт ссылается на страницу, которую вы исключаете из файла Robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что если на страницу есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, может все еще попасть в указатель , Вот что он хотел сказать в видеовстрече для веб-мастеров:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы файлом robots.txt, то теоретически может случиться так, что кто-то случайным образом сделает ссылку на одну из этих страниц. И если они это сделают, то может случиться, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.txt. Таким образом, мы бы не знали, что вы не хотите, чтобы эти страницы были действительно проиндексированы.

Принимая во внимание, что если они не заблокированы robots.txt, вы можете поместить метатег noindex на эти страницы. И если кто-то ссылается на них, и мы случайно просматриваем эту ссылку и думаем, что здесь может быть что-то полезное, мы бы знали, что эти страницы не нужно индексировать, и мы можем просто пропустить их индексацию полностью.

Таким образом, в этом отношении, если на этих страницах есть что-то, что вы не хотите индексировать, не запрещайте их, используйте вместо этого noindex .

Как создать и отредактировать файл WordPress Robots.txt

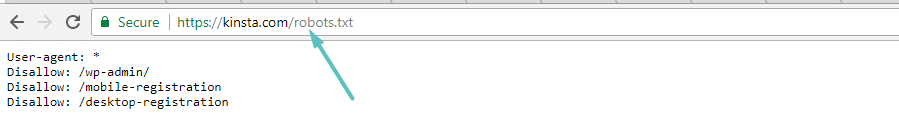

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы не поднимите палец, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец вашего доменного имени. Например, «https://kinsta.com/robots.txt» вызывает файл robots.txt, который мы используем здесь, в Kinsta:

Пример файла Robots.txt

Поскольку этот файл является виртуальным, вы не можете его редактировать. Если вы хотите отредактировать свой файл robots.txt, вам необходимо создать физический файл на вашем сервере, которым вы сможете манипулировать по мере необходимости. Вот три простых способа сделать это ...

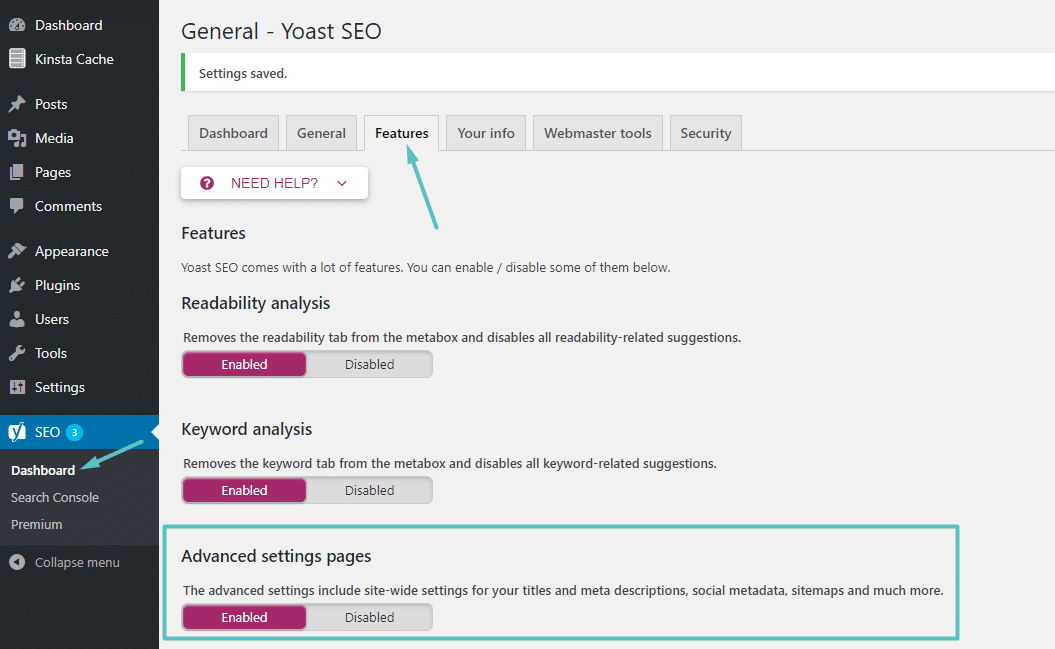

Как создать и отредактировать файл Robots.txt с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (и отредактировать) свой файл robots.txt прямо из интерфейса Yoast. Однако прежде чем вы сможете получить к нему доступ, вам нужно включить расширенные функции Yoast SEO, перейдя в раздел «SEO» → «Панель инструментов» → «Функции» и переключаясь на страницах «Дополнительные настройки» :

Как включить расширенные функции Yoast

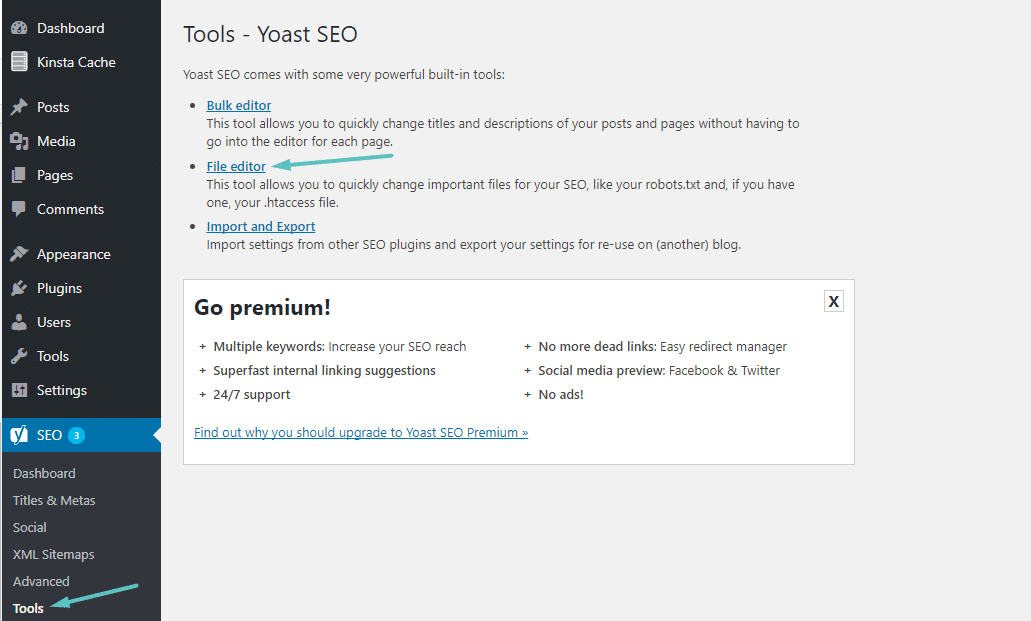

После того, как это активировано, вы можете перейти к SEO → Инструменты и нажать на Редактор файлов :

Как получить доступ к редактору файлов Yoast

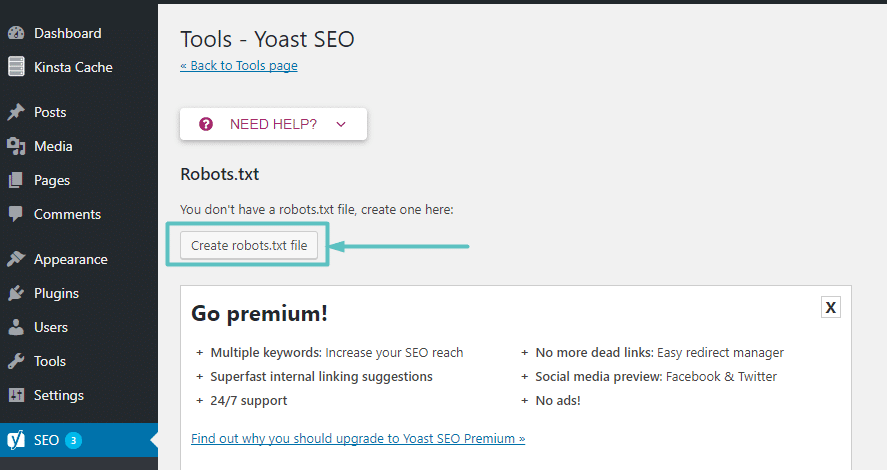

Предполагая, что у вас еще нет физического файла Robots.txt, Yoast предложит вам создать файл robots.txt :

Как создать Robots.txt в Yoast

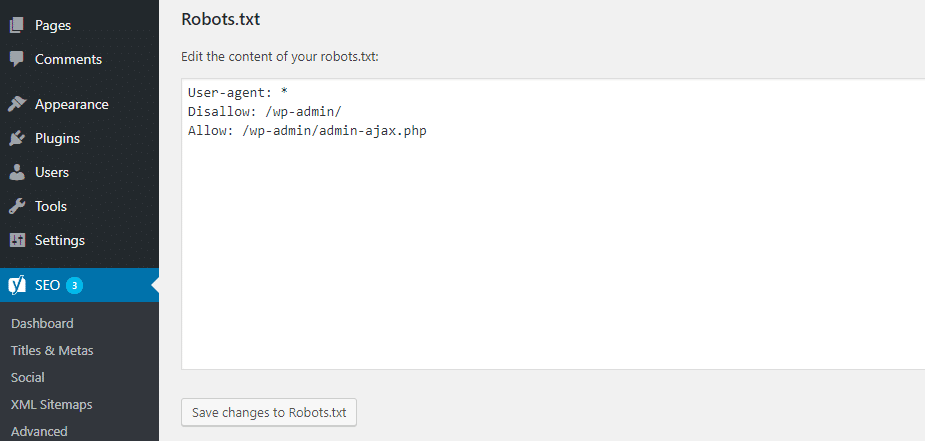

И после того, как вы нажмете эту кнопку, вы сможете редактировать содержимое файла Robots.txt непосредственно из того же интерфейса:

Как редактировать Robots.txt в Yoast

По мере того, как вы читаете дальше, мы более подробно рассмотрим, какие типы директив следует поместить в ваш файл WordPress robots.txt.

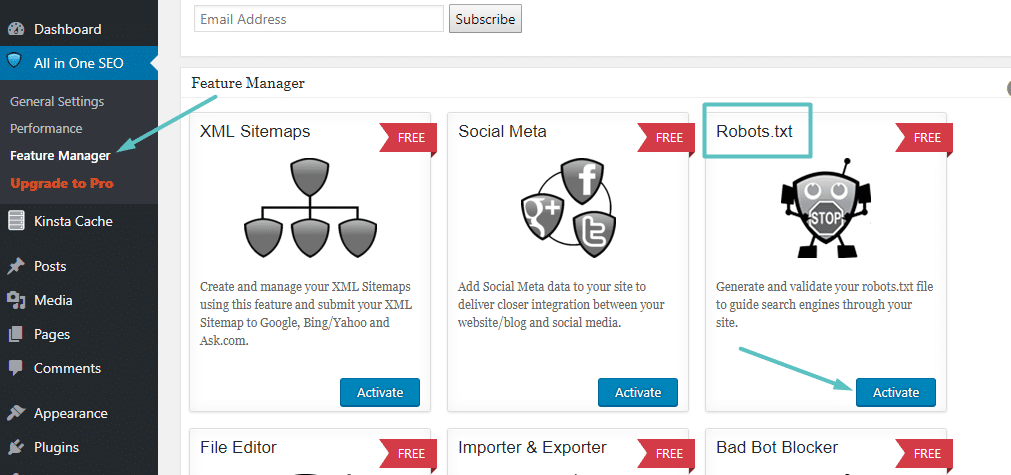

Как создать и отредактировать файл Robots.txt со всеми в одном SEO

Если вы используете плагин SEO-пакета «почти все» в формате Yoast, вы также можете создавать и редактировать файл WordPress robots.txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All in One SEO → Диспетчер функций и активировать функцию Robots.txt :

Как создать Robots.txt во все в одном SEO

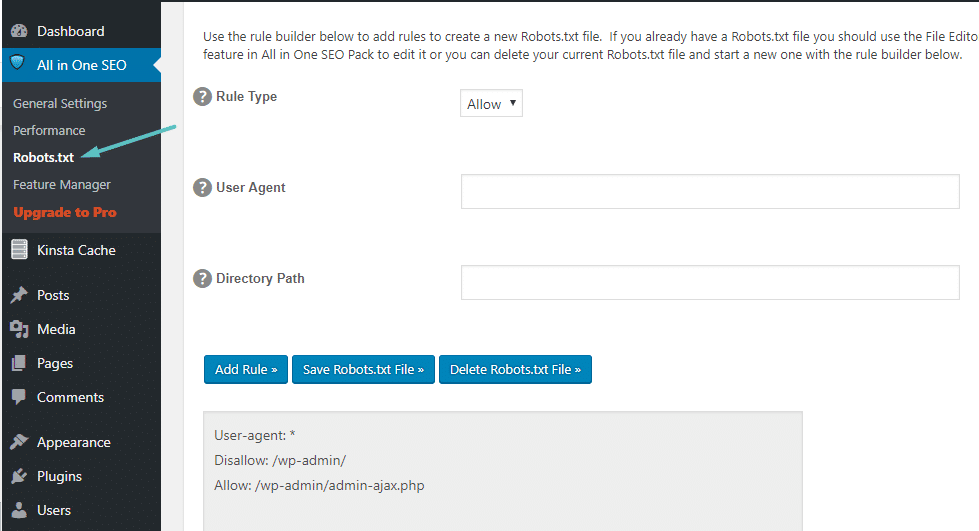

Затем вы сможете управлять своим файлом Robots.txt, перейдя в раздел Все в одном SEO → Robots.txt:

Как редактировать Robots.txt во все в одном SEO

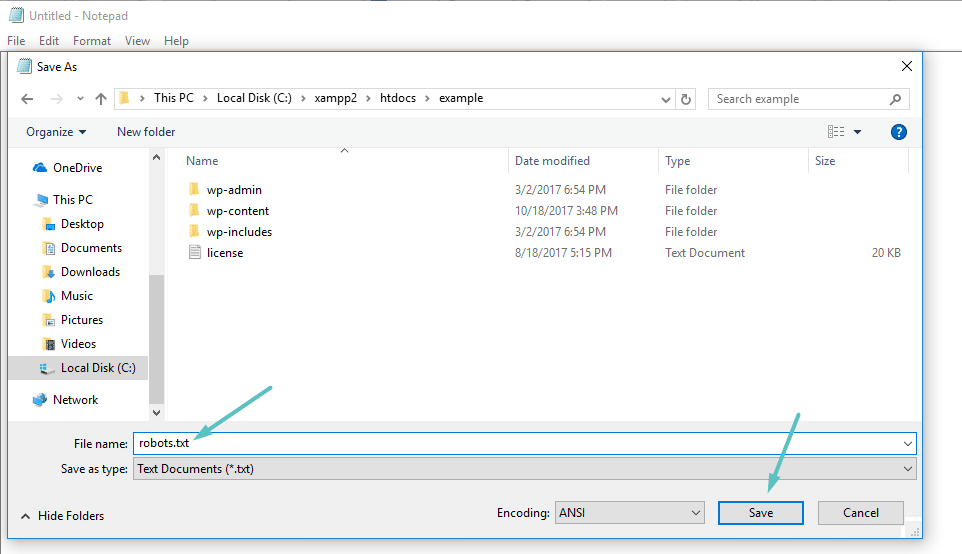

Как создать и редактировать файл Robots.txt через FTP

Если вы не используете плагин SEO, который предлагает функциональность robots.txt, вы все равно можете создавать и управлять своим файлом robots.txt через SFTP. Сначала используйте любой текстовый редактор, чтобы создать пустой файл с именем «robots.txt»:

Как создать свой собственный файл Robots.txt

Затем, подключиться к вашему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. Вы можете внести дополнительные изменения в свой файл robots.txt, отредактировав его через SFTP или загрузив новые версии файла.

Что положить в ваш файл Robots.txt

Хорошо, теперь у вас есть физический файл robots.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле делаете с этим файлом? Ну, как вы узнали из первого раздела, robots.txt позволяет вам контролировать взаимодействие роботов с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent - позволяет вам ориентироваться на конкретных ботов. Пользовательские агенты - это то, что боты используют для идентификации себя. С их помощью вы можете, например, создать правило, которое применяется к Bing, но не к Google.

- Disallow - это позволяет вам запретить роботам доступ к определенным областям вашего сайта.

Также есть команда Разрешить, которую вы будете использовать в нишевых ситуациях. По умолчанию все на вашем сайте помечено как Разрешить , поэтому нет необходимости использовать команду Разрешить в 99% случаев. Но это очень удобно, когда вы хотите запретить доступ к папке и ее дочерним папкам, но разрешить доступ к одной определенной дочерней папке.

Вы добавляете правила, сначала указывая, к какому пользовательскому агенту должно применяться правило, а затем перечисляя, какие правила применять, используя Disallow и Allow . Есть также некоторые другие команды, такие как Crawl-delay и Sitemap , но они либо:

- Игнорируется большинством основных сканеров или интерпретируется совершенно по-разному (в случае задержки сканирования)

- Сделано избыточным с помощью таких инструментов, как Google Search Console (для файлов сайтов)

Давайте рассмотрим некоторые конкретные случаи использования, чтобы показать вам, как все это происходит вместе.

Как использовать Robots.txt, чтобы заблокировать доступ ко всему сайту

Допустим, вы хотите заблокировать доступ всем сканерам к вашему сайту. Это вряд ли произойдет на живом сайте, но это пригодится для разработки сайта. Для этого вы должны добавить этот код в ваш файл WordPress robots.txt:

Пользователь-агент: * Disallow: /

Что происходит в этом коде?

Звездочка * рядом с User-agent означает «все пользовательские агенты». Звездочка - это подстановочный знак, означающий, что он применяется к каждому агенту пользователя. / Slash рядом с Disallow говорит, что вы хотите запретить доступ ко всем страницам, которые содержат «yourdomain.com/» (то есть каждую страницу на вашем сайте).

Как использовать Robots.txt, чтобы заблокировать доступ одного сайта к вашему сайту

Давайте изменим вещи. В этом примере мы представим, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы - команда Google, и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить звездочку * с Bingbot:

Пользователь-агент: Bingbot Disallow: /

По сути, приведенный выше код говорит, что применять правило Disallow можно только к ботам с пользовательским агентом «Bingbot» . Теперь вы вряд ли захотите заблокировать доступ к Bing, но этот сценарий пригодится, если есть конкретный бот, к которому вы не хотите заходить на свой сайт. Этот сайт имеет хороший список самых известных имен пользовательских агентов.

Как использовать Robots.txt, чтобы заблокировать доступ к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и всем подпапкам этой папки). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Вся папка wp-admin

- сор-login.php

Вы можете использовать следующие команды:

Пользовательский агент: * Disallow: / wp-admin / Disallow: /wp-login.php

Как использовать Robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

Хорошо, теперь давайте скажем, что вы хотите заблокировать всю папку, но вы по-прежнему хотите разрешить доступ к определенному файлу внутри этой папки. Вот где команда Allow пригодится. И это на самом деле очень применимо к WordPress. Фактически, виртуальный файл WordPress robots.txt прекрасно иллюстрирует этот пример:

Пользовательский агент: * Disallow: / wp-admin / Allow: /wp-admin/admin-ajax.php

Этот фрагмент блокирует доступ ко всей папке / wp-admin /, за исключением файла /wp-admin/admin-ajax.php .

Как использовать Robots.txt, чтобы остановить роботов от сканирования результатов поиска WordPress

Один из специфических трюков WordPress, который вы можете захотеть сделать, - запретить поисковым роботам сканировать страницы результатов поиска. По умолчанию WordPress использует параметр запроса «? S =». Таким образом, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

Пользовательский агент: * Disallow: /? S = Disallow: / search /

Это может быть эффективным способом также остановить мягкие ошибки 404 если вы их получаете.

Как создать разные правила для разных ботов в Robots.txt

До сих пор все примеры имели дело с одним правилом за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в декларацию User-agent для каждого бота. Например, если вы хотите создать одно правило, которое применяется ко всем ботам, и другое правило, которое относится только к Bingbot , вы можете сделать это следующим образом:

Пользовательский агент: * Disallow: / wp-admin / User-agent: Bingbot Disallow: /

В этом примере всем ботам будет заблокирован доступ к / wp-admin /, но Bingbot будет запрещен доступ ко всему сайту.

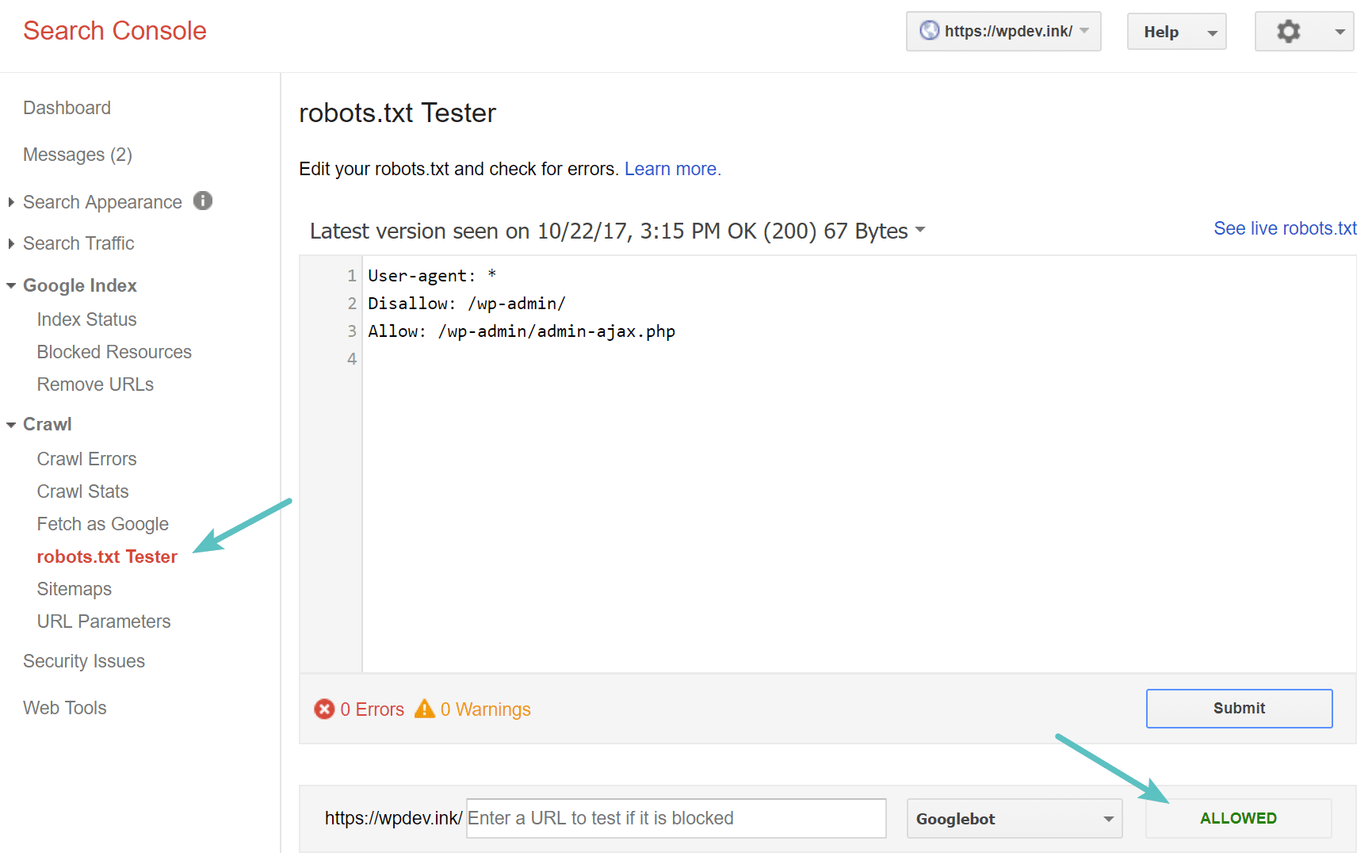

Тестирование вашего файла Robots.txt

Вы можете проверить ваш файл WordPress robots.txt в Google Search Console чтобы убедиться, что он настроен правильно. Просто нажмите на свой сайт, и в разделе «Сканирование» нажмите «robots.txt Tester». Затем вы можете отправить любой URL, включая свою домашнюю страницу. Вы должны увидеть зеленый Разрешено, если все можно сканировать. Вы также можете проверить заблокированные URL-адреса, чтобы убедиться, что они действительно заблокированы и / или запрещены .

Тестовый файл robots.txt

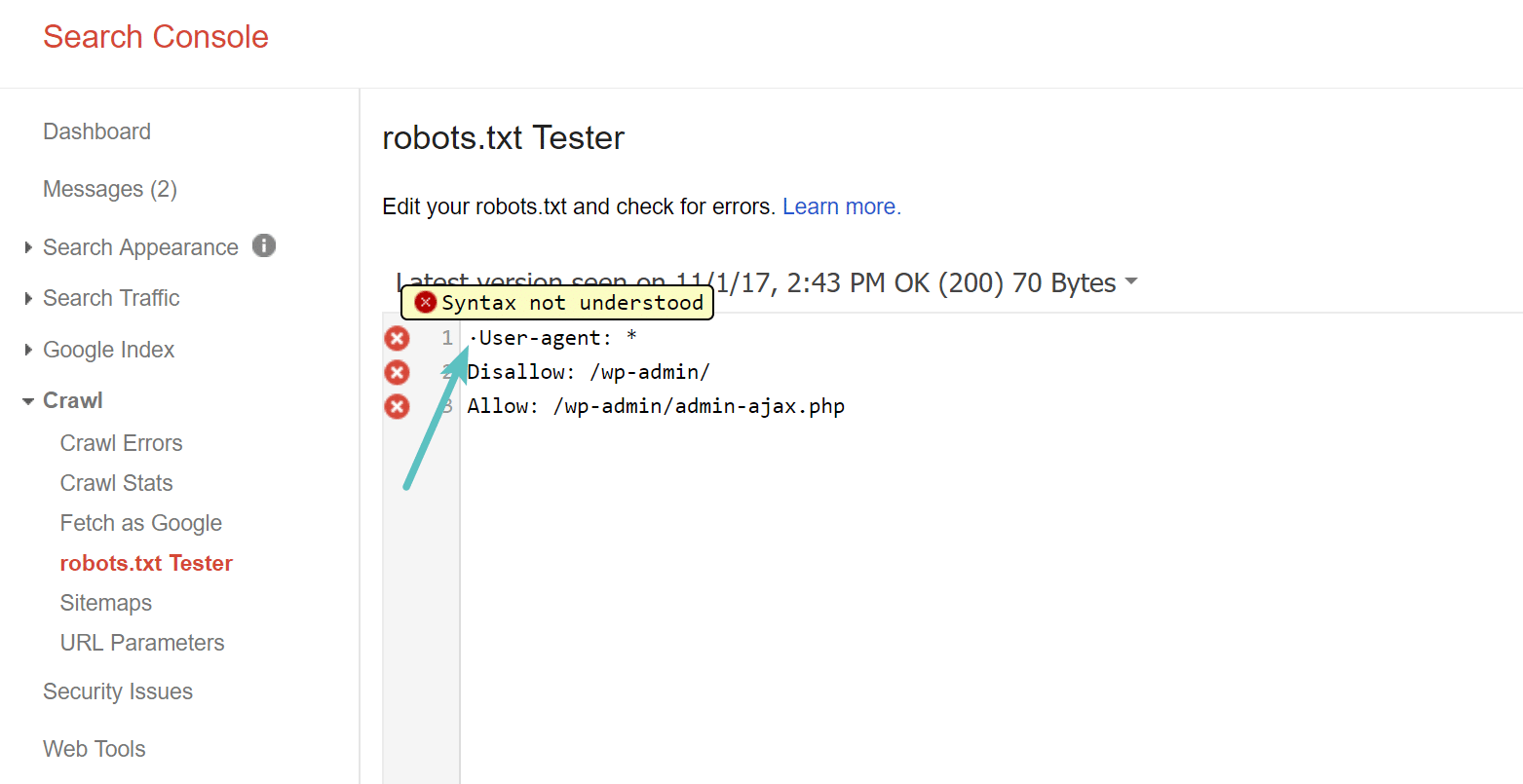

Остерегайтесь спецификации UTF-8

Спецификация обозначает метку порядка байтов и в основном является невидимым символом, который иногда добавляется в файлы старыми текстовыми редакторами и т.п. Если это происходит с вашим файлом robots.txt, Google может не прочитать его правильно. Вот почему важно проверить ваш файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется, что синтаксис не понят. Это фактически делает недействительной первую строку нашего файла robots.txt, что не очень хорошо! Гленн Гейб имеет отличную статью о том, как UTF-8 Bom может убить вашего SEO ,

UTF-8 BOM в вашем файле robots.txt

Googlebot в основном в США

Также важно не блокировать робота Google из США, даже если вы ориентируетесь на местный регион за пределами США. Иногда они выполняют локальное сканирование, но робот Google в основном базируется в США .

Какие популярные сайты WordPress помещают в свои файлы Robots.txt

Чтобы фактически обеспечить некоторый контекст для пунктов, перечисленных выше, вот как некоторые из самых популярных сайтов WordPress используют свои файлы robots.txt.

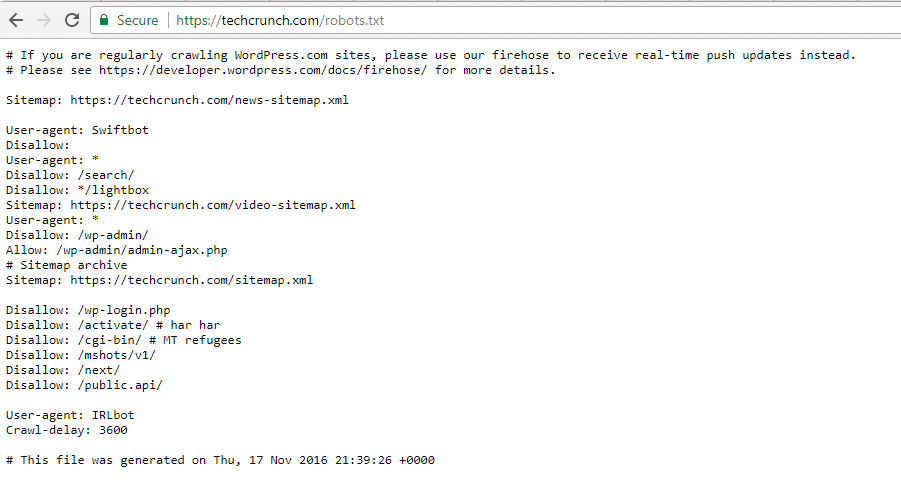

TechCrunch

Файл TechCrunch Robots.txt

В дополнение к ограничению доступа к ряду уникальных страниц TechCrunch особенно запрещает сканерам:

Они также устанавливают специальные ограничения для двух ботов:

Если вам интересно, IRLbot - сканер из исследовательского проекта Техасского университета A & M , Это странно!

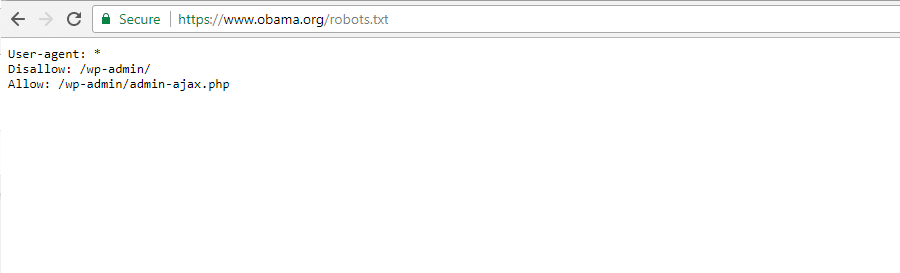

Фонд Обамы

Обама Фонд Robots.txt Файл

Фонд Обамы не внес никаких особых дополнений, решив исключительно ограничить доступ к / wp-admin /.

Angry Birds

Файл Angry Birds Robots.txt

Angry Birds имеет те же настройки по умолчанию, что и The Obama Foundation. Ничего особенного не добавлено.

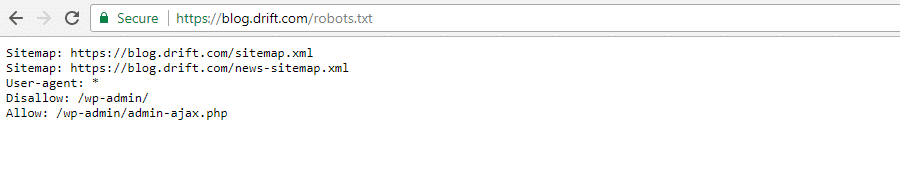

дрейф

Дрифт Robots.txt Файл

Наконец, Drift предпочитает определять свои карты сайта в файле Robots.txt, но в остальном оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Используйте Robots.txt правильный путь

Завершая наше руководство по robots.txt, мы хотим еще раз напомнить вам, что использование команды Disallow в вашем файле robots.txt отличается от использования тега noindex . Robots.txt блокирует сканирование, но не обязательно индексирует. Вы можете использовать его для добавления определенных правил, чтобы определить, как поисковые системы и другие боты взаимодействуют с вашим сайтом, но он не будет явно контролировать, проиндексирован ли ваш контент или нет.

Для большинства случайных пользователей WordPress нет необходимости срочно изменять виртуальный файл robots.txt по умолчанию. Но если у вас проблемы с конкретным ботом или вы хотите изменить взаимодействие поисковых систем с определенным плагином или темой, которую вы используете, вы можете добавить свои собственные правила.

Мы надеемся, что вам понравилось это руководство, и обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы об использовании файла WordPress robots.txt.

Похожие

WordPress SEO... robots.txt Каноническое веселье Распространенная ошибка в SEO с WordPress связана с тегом канонической ссылки Некоторые плагины SEO пропускают косую черту в URL, которые многие веб-серверы, кроме 301, перенаправляют на URL «/». Другие просто отвечают любым URL в браузере Проверьте свои, добавив /? Test = 123 в конец URL вашей домашней страницы Я не сказал, что ... не так ли? Что такое SEO?

... использоваться повторно в тексте. Но не переусердствуйте: читатели и сканеры поисковых систем не любят спам по ключевым словам. В мета-описании содержание соответствующей страницы для поисковой системы и пользователя будет суммировано С уникальным и актуальным контентом у вас есть возможность отличиться от конкурентов. Предпочтительно, чтобы тексты включали около 300 слов, а также перечисления, нумерацию и таблицы, чтобы сделать контент максимально удобным для пользователя. Почему вы должны аутсорсинг SEO

... вая оптимизация (SEO) - это набор процессов, предназначенных для успешной конкуренции за лучшие органические рейтинги с помощью поиска по ключевым словам"> Поисковая оптимизация (SEO) - это набор процессов, предназначенных для успешной конкуренции за лучшие органические рейтинги с помощью поиска по ключевым словам. Как правило, хорошо известно, что доступ к верхним страницам, даже к странице 1, имеет первостепенное значение Что такое SEO консультант

Первый английский термин SEO Поисковая оптимизация означает, по-французски это поисковая оптимизация. SEO консультант - это Robots.txt

... txt в одну и ту же категорию, поскольку они по-разному выполняют схожие вещи. Один из них - файл, другой - HTML-тег, однако оба они могут разрешить или помешать поисковым роботам сканировать ваш сайт. Файл robots.txt - это файл, который вы создаете и который существует на вашем сервере. Он сообщает таким ботам, как Google и Bing (а также некоторым «плохим» ботам), где сканировать, а где не сканировать. Этот файл в основном служит руководством для ботов, чтобы показать им, где, а иногда SEO Консалтинг

В SEO есть наука, которая может показаться очень пугающей. Но на самом деле, при правильном руководстве, ваша команда может успешно интегрировать поисковую оптимизацию в ваш сайт и блог, чтобы повысить авторитет вашего сайта - что, в свою очередь, может повысить рейтинг вашего сайта в результатах естественного поиска. Что это SEO-консалтинг рассматривает, как работает SEO, и почему это важно для долгосрочного успеха вашего сайта и блога. Далее мы рассмотрим практический Как работает SEO маркетинг?

... использовать ваши концепции очень дифференцированным образом. Таким образом, трудно точно определить точную форму. Теперь, когда мы теоретически определили, что такое SEO-маркетинг и как он работает, я чувствую, что даже после полученной мной информации я не смог здесь закрыться, потому что считаю, что не все было так ясно, как хотелось бы. Поэтому я сломал голову, пытаясь найти способ объяснить на практике, как работает приложение SEO-маркетинга. После долгих размышлений Как использовать Platinum SEO Pack для WordPress

... ворят, что поисковая оптимизация является ключевым фактором успеха сайта. Конечный продукт делает сайт более удобным для поисковых систем. Platinum SEO Pack обладает множеством функций и предлагает большую гибкость для своих пользователей. SEO: определение. Что это такое, что это значит и что означает SEO

... как поисковая оптимизация, что на итальянском языке можно перевести как « оптимизация для поисковых систем (и для пользователей, которые их используют) ». Определенно трудно дать однозначное определение, так как понятие очень широкое. Однако в следующих нескольких строках я попытаюсь дать свою собственную интерпретацию того, что такое SEO. SEO - это набор методов и стратегий, которые позволяют пользователям находить веб-сайт в поисковых системах (среди В конце концов, что такое SEO вне страницы?

В рамках SEM, которая является маркетингом в поисковых системах, является SEO, объединяющее методы, позволяющие сделать сайт органически доступным к вершине результатов поиска (особенно Google). SEO метатеги

Мета-теги Seo или мета-элементы используются при создании страниц HTML и XHTML. Включая эти теги, можно предоставлять важные и одинаково структурированные метаданные, относящиеся к веб-сайту, поисковые системы пройти. В зависимости

Комментарии

После того, как вы преуспели в ранжировании своих страниц, почему бы не продавать свои услуги местным компаниям и получить их сайт, чтобы занять более высокое место в поисковых системах?После того, как вы преуспели в ранжировании своих страниц, почему бы не продавать свои услуги местным компаниям и получить их сайт, чтобы занять более высокое место в поисковых системах? На самом деле, бизнес даже не должен быть в вашем районе. Если вы создаете сайт и занимаете его высокое место в поисковых системах, у вас не должно возникнуть проблем с его продажей. Какие страницы не должны отсутствовать на вашем веб-сайте, что такое высококачественный веб-сайт и почему навигация и структура URL жизненно важны для хорошего SEO?

Какие страницы не должны отсутствовать на вашем веб-сайте, что такое высококачественный веб-сайт и почему навигация и структура URL жизненно важны для хорошего SEO? РЕКОМЕНДУЕТСЯ ДЛЯ ВАС: Управление сайтом WordPress? Затем скачайте это руководство и узнайте, как оптимизировать ваш сайт как профессионал. Если вы серьезно принимаете во внимание эти 2 фактора, а именно структуру веб-сайта и советы по поисковой оптимизации, то это все, что вам нужно сделать, чтобы поисковые Что это такое, что вы хотите сделать, чтобы это не было?

Что это такое, что вы хотите сделать, чтобы это не было? Рюссы, Рюссы, Сьюзен, Ривер, Рюсон, Рюсон, Рюсон, Рюсон, Рюсон РμРμ СѓСЃР »СѓРіРё В« , Є Ђ є є,,,,,,,,,,,,,, Выезд, Россия, Россия, Россия, Россия, Россия, Россия, Франция, Россия, Россия Приключенческие, фьючерсные, фьючерсные, слисские, рёсские, рёсские, флисские Причал, Россия, Россия, Россия, Франция, Франция, Франция. Ї »»Р Рμ» Р Р »» »»μμμμ» »»μμ» SEO маркетинг - что это такое и как это работает?

SEO маркетинг - что это такое и как это работает? Вы можете найти заголовок содержащий два вопроса, не так ли? Если вы следили за этим каналом в течение некоторого времени, вы, должно быть, поняли, что мне всегда нравится объяснять и разделять тексты. Тем не менее, чтобы более четко следовать цели этой статьи, я не видел другой возможности объяснить вам, как работает SEO-маркетинг, не объяснив, Не знаете, что это такое или как вы могли бы его настроить?

Не знаете, что это такое или как вы могли бы его настроить? Ну я же написала статья только для тебя. Google+ Это звучит слишком хорошо, чтобы быть правдой, но Google любит сканировать сайты, которые люди делят в своей социальной сети. Так что если вы создали какой-то потрясающий контент, поделитесь им на Google+ сразу, и это, вероятно, будет Почему бы по крайней мере не заняться основами, чтобы дать вашему бренду наилучшую возможность добиться успеха с SEO и изображений в Google и других поисковых системах?

Не знаете, что это такое или как вы могли бы его настроить? Ну я же написала статья только для тебя. Google+ Это звучит слишком хорошо, чтобы быть правдой, но Google любит сканировать сайты, которые люди делят в своей социальной сети. Так что если вы создали какой-то потрясающий контент, поделитесь им на Google+ сразу, и это, вероятно, будет Кроме того, разве не приятно видеть, что страницы результатов поиска и страницы ошибок 404 «not found» также имеют для вас значение «noindex»?

Кроме того, разве не приятно видеть, что страницы результатов поиска и страницы ошибок 404 «not found» также имеют для вас значение «noindex»? Спасибо Йост де Валк! Социальный (OpenGraph) Этот раздел позволяет вам добавлять метаданные OpenGraph на Facebook и Twitter на ваш сайт ... что помогает защитить ваш бренд в социальных сетях! Яя! Больше не будут Главным образом на техническом сайте, потому что как часто вы вносите изменения в детали META или в элементы страницы и забываете, что они могут повлиять на SEO?

Главным образом на техническом сайте, потому что как часто вы вносите изменения в детали META или в элементы страницы и забываете, что они могут повлиять на SEO? Этот инструмент будет отслеживать его, только те инструменты, которые я знаю в этой области, которые действительно полезны. Для больших сайтов, инвестиции того стоят. Вы делаете ошибку и делаете ошибку во много раз дороже. Также взгляните на Little Warden, если вы ищете что-то подобное, они также отслеживают тонны метрик и элементов, В конце концов, это был 2014 год, и Google должен быть достаточно умен, чтобы это не имело никакого значения, потому что они знают, что блог (поддомен или нет) является частью iwantmyname, верно?

В конце концов, это был 2014 год, и Google должен быть достаточно умен, чтобы это не имело никакого значения, потому что они знают, что блог (поддомен или нет) является частью iwantmyname, верно? Как сказал Мэтт Каттс в одном из его видео для веб-мастеров «Вопрос в том, какой из них тебе легче, и какой бы ты ни делал тебя счастливее, я бы пошел и сделал так». Хотя мы ожидали первоначального попадания после переключения Кроме того, как вы можете быть уверены, что любая из предложенных кривых кликов применима к вашему сектору рынка, вертикали поиска или бренду?

Кроме того, как вы можете быть уверены, что любая из предложенных кривых кликов применима к вашему сектору рынка, вертикали поиска или бренду? Ниже приведена методология, которую я использовал для определения CTR SERP сайта, используя данные, полученные с самого сайта, а не отраслевые исследования. Во-первых, я должен сказать, что, изучая научные методы, в этой процедуре есть ряд предостережений, которые никоим образом не являются точным решением. Вместо этого он используется Знаете ли вы, что такое SEO на странице и как это может негативно повлиять на ваш рейтинг?

Знаете ли вы, что такое SEO на странице и как это может негативно повлиять на ваш рейтинг?" Не удивительно, что Цифровой маркетинг хорошо сделанный зависит также от поисковой оптимизации, SEO. Но даже те, кто осознает важность этой оптимизации, могут совершать ошибки, и

Txt?

Txt?

Txt и задавались вопросом, как он применяется к вашему сайту?

Txt?

Txt?

Но что вы на самом деле делаете с этим файлом?

По умолчанию WordPress использует параметр запроса «?

Но что, если вы хотите применить разные правила к разным ботам?

Другие просто отвечают любым URL в браузере Проверьте свои, добавив /?

Не так ли?